🪢 L’AI Act européen, comprendre les clés de la première régulation mondiale de l’intelligence artificielle

Les décisions politiques s'accélèrent, les innovations technologiques bousculent les lignes : quelles garanties avons-nous pour que l’intelligence artificielle serve réellement l’intérêt général ?

Chers Insiders,

J’espère que vous avez passé un bon weekend prolongé !

Que vous soyez restés en famille ou que vous en ayez profité pour passer du bon temps entre amis, j’espère que vos avez eu l’occasion de lever le nez de vos téléphones portables pour débattre de façon ouverte et constructive avec vos proches. Il faut dire qu’il y a matière à confronter les opinions… et ce n’est pas prêt de s’arrêter.

Bonne lecture et à la semaine prochaine !

🪢 Daphnée d’IA Éthique Insider

Les News de la semaine en bref

🤓 Général

Meta menacé de perdre Instagram et WhatsApp ? (lecture de 4 minutes)

Le géant américain Meta est poursuivi par la Commission Fédérale du Commerce (FTC) pour avoir abusé de sa position dominante lors du rachat de WhatsApp et Instagram. Cette affaire devient un cas d’école sur la capacité des régulateurs à imposer des règles face aux Big Tech. Elle interroge sur le respect effectif des droits fondamentaux en matière de protection des consommateurs. Une affaire à suivre de près, qui pourrait ouvrir la voie à d'autres décisions similaires ailleurs dans le monde.

Choose France for Science : un levier stratégique pour une recherche plus responsable (lecture de 3 minutes)

L’ANR lance une plateforme visant à attirer les chercheurs internationaux en France, dans un contexte de compétition mondiale pour les talents scientifiques. Si l’objectif est de renforcer la recherche nationale, cette initiative pose aussi la question de l’alignement des projets accueillis avec des principes éthiques, notamment dans les domaines sensibles comme l’IA ou la biotechnologie. Une recherche ouverte et internationale, qui ne doit pas perdre de vue l’impératif de responsabilité scientifique et l’indépendance des travaux menés, particulièrement dans les domaines à fort impact sociétal.

Wikimedia et Kaggle : rendre les données publiques plus accessibles aux chercheurs et développeurs (lecture de 4 minutes)

Wikimedia Enterprise collabore avec Kaggle pour rendre ses jeux de données plus facilement exploitables par la communauté scientifique et les développeurs. Cette initiative vise à favoriser l’entraînement de modèles d’IA sur des bases de données ouvertes, améliorant ainsi la transparence et la reproductibilité des recherches. Un enjeu crucial pour limiter la dépendance aux données propriétaires des géants du numérique et favoriser une innovation plus éthique, où les biais liés aux jeux de données fermés peuvent être mieux identifiés et corrigés. Cette démarche pourrait devenir un modèle pour d’autres initiatives de science ouverte.

⚖️ Fairness

Progen3 : l’IA qui génère des protéines relance le débat sur l’équité biotechnologique (lecture de 5 minutes)

Profluent dévoile Progen3, une IA capable de générer de nouvelles séquences de protéines. Cette innovation ouvre des perspectives impressionnantes pour le développement de traitements médicaux et de biotechnologies de pointe. Mais elle soulève aussi des questions éthiques majeures : qui aura accès à ces avancées ? Comment garantir qu’elles ne creusent pas davantage les inégalités entre pays ou acteurs économiques ? Le risque d'une "biotechnologie à deux vitesses", réservée à ceux qui peuvent se l’offrir, est bien réel. Une réflexion nécessaire sur la gouvernance de ces technologies et la répartition équitable de leurs bénéfices.

Google offre l’accès à son IA premium aux étudiants : une avancée vers plus d’inclusion ou une stratégie de dépendance ? (lecture de 4 minutes)

Google propose gratuitement son offre Gemini AI Premium aux étudiants, avec l’ambition affichée de démocratiser l’accès à l’IA de pointe. Si cette initiative peut réduire certaines barrières, elle interroge aussi sur les réelles conditions d’éligibilité et sur la stratégie sous-jacente de fidélisation précoce de futurs professionnels captifs de l’écosystème Google. Un exemple de plus où inclusion numérique et stratégie commerciale s’entremêlent.

Meta veut protéger les adolescents : progrès ou écran de fumée ? (lecture de 4 minutes)

Meta annonce de nouvelles fonctionnalités pour mieux encadrer les comptes des adolescents, avec des outils de contrôle parental et de limitation des interactions. Si ces mesures vont dans le bon sens, de nombreux experts pointent le manque de transparence sur les algorithmes de recommandation qui façonnent l’expérience des jeunes utilisateurs. Derrière les annonces, c’est la question de la responsabilité des plateformes dans la construction de l’environnement numérique des plus vulnérables qui reste ouverte. Une vigilance accrue s’impose.

🌱 Sustainability / environnement

OpenAI arrête GPT-4.5 : sobriété énergétique ou repositionnement stratégique ? (lecture de 5 minutes)

OpenAI annonce la fin progressive de GPT-4.5, son plus imposant modèle à ce jour. Cette stratégie soulève la nécessité de répondre à une pression croissante autour de la soutenabilité des modèles de grande taille, particulièrement voraces en consommation d’énergie, et à l’évolution du marché vers des systèmes plus efficients. Cette annonce aurait dû relancer le débat sur l’arbitrage entre performance technologique et responsabilité écologique… Les médias semblent avoir raté le coche… cette question est pourtant centrale dans l’avenir du développement de l’IA.

L’empreinte énergétique des modèles d’IA : pourquoi il faut sortir du flou (lecture de 3 minutes)

HuggingFace vient de sortir ChatUI, un outil disponible sur la plateforme de la firme permettant de calculer la consommation en énergie d’une requête en temps réel, et permet d’avoir des équivalents de consommation d’énergie évocateurs et intelligibles. L’outil rappel que chaque petit geste compte ! Ce projet, avec d’autres initiatives telles que le AI Energy Score, a pour but de pousser la transparence autour de la consommation énergétique des modèles d’IA au sein de la communauté Open Source.

🔓 Safety

Souveraineté numérique : une réalité sans maîtrise technique ? (lecture de 4 minutes)

Dans une tribune au Monde, plusieurs experts alertent : sans capacité industrielle locale, la souveraineté numérique européenne reste une illusion. Derrière la maîtrise du cloud, des data centers ou des puces électroniques, se joue la possibilité réelle de contrôler le développement des technologies stratégiques comme l’IA. Cette analyse rappelle que la souveraineté ne peut être seulement juridique : elle implique aussi des moyens techniques concrets pour garantir autonomie, sécurité et éthique.

Anticiper les dérives de l’IA : la méthode Anthropic (lecture de 5 minutes)

Anthropic dévoile sa démarche systématique d’identification des risques liés à ses modèles d’IA, basée sur l’évaluation des usages sensibles dès la phase de conception. Cette approche "safety by design" vise à prévenir les dérives plutôt que de les corriger a posteriori. En analysant les contextes potentiels de mésusage, Anthropic renforce la robustesse et la sécurité de ses systèmes. Une démarche qui pourrait bien devenir un standard dans le secteur, face aux scandales liés à l’inaction préventive de certains acteurs historiques.

DeepMind veut apprendre à ses IA par expérience : avancée technique ou boîte de Pandore ? (lecture de 5 minutes)

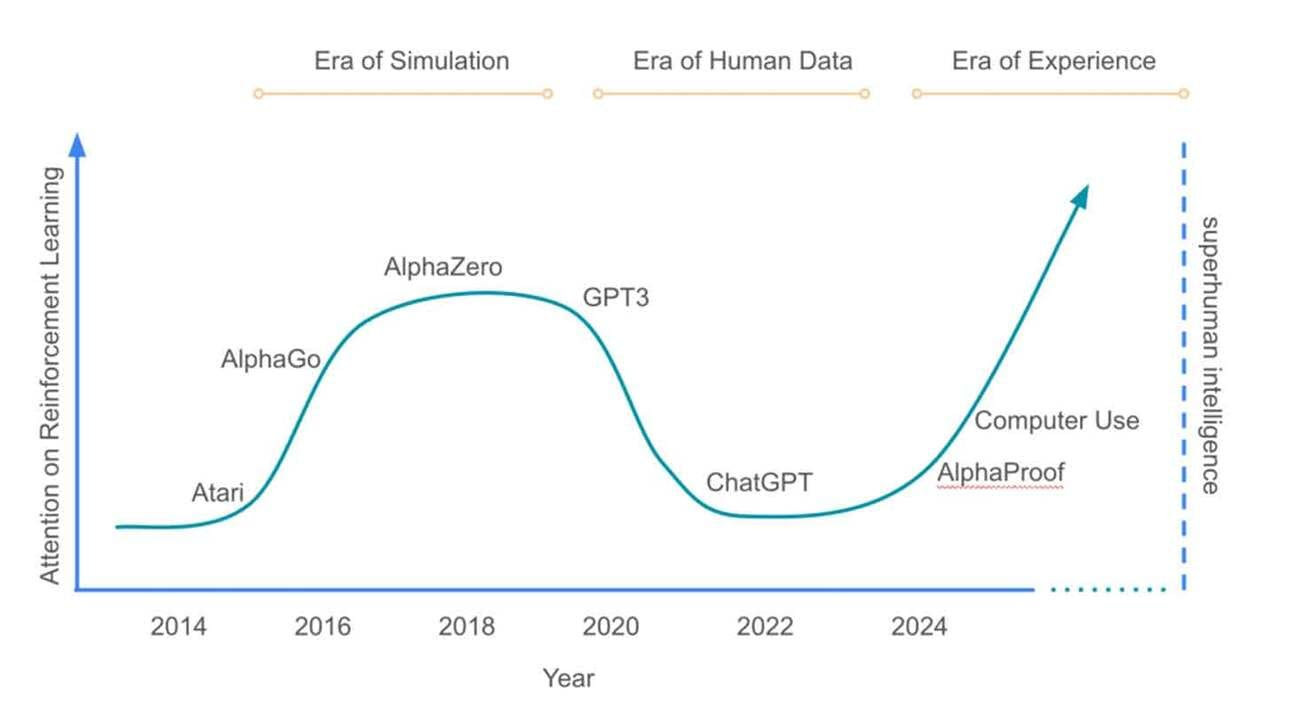

DeepMind propose une nouvelle approche de l’apprentissage des IA : l’entraînement par flux d’expériences réelles ("streams"), dépassant les limites des jeux de données humains. Cette méthode permettrait aux IA de s’adapter en continu, via des interactions prolongées avec leur environnement, ouvrant la voie à des découvertes inédites. Mais cette autonomie accrue soulève des questions fondamentales de sécurité, de contrôle et de responsabilité. Comment s’assurer qu’un système capable de dépasser l’expertise humaine reste aligné avec nos valeurs ? Le débat est lancé.

Fiche mémo

L’AI Act européen, comprendre les clés de la première régulation mondiale de l’intelligence artificielle

Si l’UE est souvent critiquée pour sa lourdeur administrative et sa bureaucratie, elle peut néanmoins se féliciter de ne pas foncer tête baisser dans la course à l’IA et de prendre les mesures nécessaires à l’encadrement de ces technologies dont les réelles implications et capacités nous dépassent déjà largement.

Je vous propose cette semaine une petite fiche mémo au sujet de l’AI Act. Il ne s’agit pas là d’une analyse critique du texte mais simplement de vous aider à comprendre ses principes directeurs.

La règlementation suit toujours difficilement la rapidité des développements technologiques, et cela est aujourd’hui plus vrai que jamais. Aussi, le cadre légal ne se suffira jamais à lui-même et il nous faudra une combinaison de dispositifs et d’initiatives savamment orchestrés pour garantir la protection des intérêts, des valeurs et de la liberté des citoyens européens.

C’est sur cette toile de fond que l’AI Act a vu le jour. Il a été rédigé par le Parlement européen, la Commission européenne et le Conseil de l’Union avec la participation d’experts, d’ONGs, d’industriels et de chercheurs.

Ce texte adopté en 2024 pour une mise en application progressive à partir de 2025, est le premier cadre légal au monde dédié à l’encadrement de l’intelligence artificielle.

L’AI Act est applicable dans l’ensemble des pays membres de l’UE mais aussi aux entreprises hors UE qui souhaitent accéder au marché européen avec leurs technologies.

Il adopte une méthodologie basée sur une classification des systèmes d’IA selon leur niveau de risque : minimal, limité, élevé ou inacceptable et se concentre particulièrement sur l’encadrement des IA au risque élevé. Ce sont ces IA qui sont soumises aux contraintes les plus fortes.

Il y a également une section dédiée aux GPAI (General Purpose AI), soit les modèles fondamentaux tels que ChatGPT et consorts, avec une distinction entre les modèles Open source versus les modèles Closed source.

Le texte interdit notamment certains usages tels que :

Déploiement de techniques subliminales, manipulatrices ou trompeuses

Exploitation de vulnérabilités

Systèmes de catégorisation biométrique

Notation sociale

Évaluation du risque qu'un individu commette des infractions pénales uniquement sur la base de son profilage ou de ses traits de personnalité, sauf exception

Compilation de bases de données de reconnaissance faciale par extraction non ciblée d'images faciales sur Internet ou d'images de vidéosurveillance

Déduction d'émotions sur les lieux de travail ou dans les établissements d'enseignement

Sauf exception, identification biométrique à distance (RBI) « en temps réel » dans les espaces publics accessibles aux forces de l'ordre

D’autres types d’usages (recrutement, santé, éducation) seront soumis à des obligations strictes de transparence, d’explicabilité et d’auditabilité.

L’AI Act considère qu’une grande partie de la responsabilité repose sur les développeurs de solutions et considère les utilisateurs de ces solutions comme des déployeurs. Ces derniers portent également une certaine responsabilité.

Un cadre spécifique visant à alléger les obligations pour les PMEs est également prévu, via la mise en place de “sandbox” permettant l’expérimentation pour certains système en accord avec la règlementation. L’objectif est de ne pas trop freiner l’innovation. Je vous ai préparé une petite présentation explicative pour les PMEs.

En définitive, l’objectif de l’AI Act est de prévenir les dérives de l’intelligence artificielle : discriminations, atteintes aux droits fondamentaux, risques pour la sécurité et la santé des citoyens. Il s’agit de poser les bases d’une innovation éthique, alignée avec les valeurs démocratiques de l’UE.

Le raté de l’IA de la semaine

Le chatbot de support Cursor AI invente une politique de sécurité totalement fictive, provoquant l’incompréhension et la colère des utilisateurs. Une erreur due aux "hallucinations" des modèles génératifs qui rappelle l’urgence de renforcer la vérification humaine et les garde-fous dans les systèmes de support automatisés. - 17/04/2025.

Coup de coeur de la semaine

Source : CppLoops

Le sondage de la semaine

✨ Rejoignez la communauté IA Ethique Insider ! ✨

Merci d’avoir pris le temps de me lire !

Si cette newsletter vous a fait réfléchir, surpris(e) ou inspiré(e), alors partagez-la avec votre réseau ! Plus nous serons nombreux à questionner et façonner une IA responsable, plus nous pourrons avoir des débats riches et constructifs pour façonner un monde plus harmonieux où la technologie serait au service du vivant.

💌 Pas encore abonné(e) ? Inscrivez-vous pour ne rien manquer des prochaines éditions !

Vous pensez que cela pourrait intéresser quelqu'un ? Partagez sans compter la newsletter !

Sinon, vous pouvez aussi faire entendre votre voix : répondez à ce mail avec vos réactions, vos idées ou les sujets que vous aimeriez voir abordés. Hâte d’échanger ensemble !

P.S. Les résumés sont générés par IA et corrigés par mes soins.

Intéressante cette news, elle ouvre d'autres perspectives 😉

J'aussi bien aimé le coup de coeur 🤣